Fokus: Forschungspartnerin KI

Einmal Algorithmus drüber, und schon gelingt’s

In der Forschung wird Künstliche Intelligenz schon seit langem angewandt. Sechs laufende Projekte, in der sie ganz besondere Fortschritte ermöglicht.

Dem bösartigen Tumor den Garaus machen

Schnell wachsende Hirntumoren zu behandeln erfordert rasche Entscheidungen. Dafür verlassen sich die Ärzte auf MRT-Bilder. Mauricio Reyes vom Artorg Center der Universität Bern erforscht seit zehn Jahren das besonders aggressive Glioblastom. Seit vergangenem Jahr setzt er für die Voraussage des Wachstums auf ein KI-System, das verschiedene Bestandteile des Tumors erkennen kann. Es soll anhand der Aufnahmen aggressive von weniger aktiven Glioblastomen unterscheiden können. Im ersten Fall liegt die Überlebensprognose bei durchschnittlich 16 Monaten, im zweiten bei mehreren Jahren. Diese Unterscheidung ist also ein zentraler Faktor für Therapieentscheidungen. «KI-Systeme helfen vor allem, Zeit zu gewinnen», sagt Reyes.

Beim Training dieser KI ging es zunächst darum, dass das System lernt, den Tumor auf den Scans in Bereiche zu unterteilen: in abgestorbene Regionen, in aktive Zonen, in denen sich die Krebszellen rasch vermehren, und in Randbereiche, in denen entzündliche Prozesse dominieren. Aus der Entwicklung dieser Zonen sollte das System lernen, unterschiedlich aggressive Varianten zu erkennen. Mit Erfolg: Die KI konnte Tumorvarianten mit einer Genauigkeit von 88 Prozent vorhersagen. «Allerdings wussten wir nicht, auf welcher Basis die KI ihre Entscheidungen traf», erklärt Reyes. «Wir haben es oft mit Blackbox-Systemen zu tun.»

Also wollte Reyes verstehen, welche Pixel die KI verwendete. «Wir fanden heraus, dass sie vor allem auf die Randbereiche des Tumors schaute, nicht aber auf die aktiven Zonen. Das war falsch.» Shortcut-Learning nennen Forschende das Phänomen. Dabei liefern KI-Systeme zwar halbwegs richtige Aussagen, aber aus den falschen Gründen. Sich blind auf Blackbox-Systeme zu verlassen, kann gerade in der Medizin fatale Folgen haben. Reyes schloss nun die Randbereiche des Tumors für die Bewertung aus. Sie haben nämlich genau wie abgestorbene Regionen kaum einen Informationsgehalt. Die Vorhersagegenauigkeit der KI stieg daraufhin auf 98 Prozent. Der Berner Forscher hält es für dringend notwendig, künftig KI zu entwickeln, die die Qualität von KI kontrollieren kann. Sein nächstes Projekt lautet daher «KI für KI». Bisher gebe es so etwas nicht.

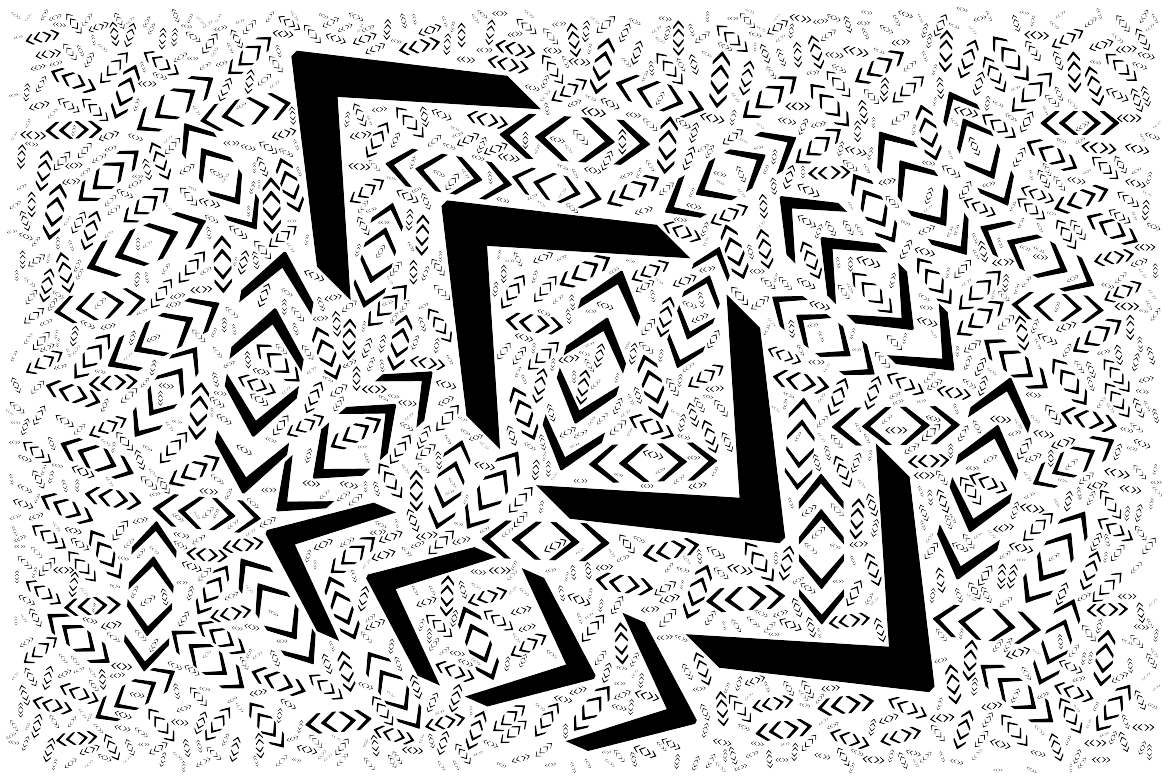

Im Rausch einer möglichen neuen Physik

Mit der Entdeckung des Higgs-Bosons am Large Hadron Collider (LHC) des Cern in Genf war das Standardmodell der Physik vollständig belegt. Wichtige Teilkräfte wie die starke, die schwache und die elektromagnetische Wechselwirkung waren verstanden. Die Beschreibung des Universums bleibt allerdings unvollständig, da sich Phänomene wie die dunkle Energie und die dunkle Materie damit nicht erklären lassen. Sehr wahrscheinlich existieren also weitere Teilchen.

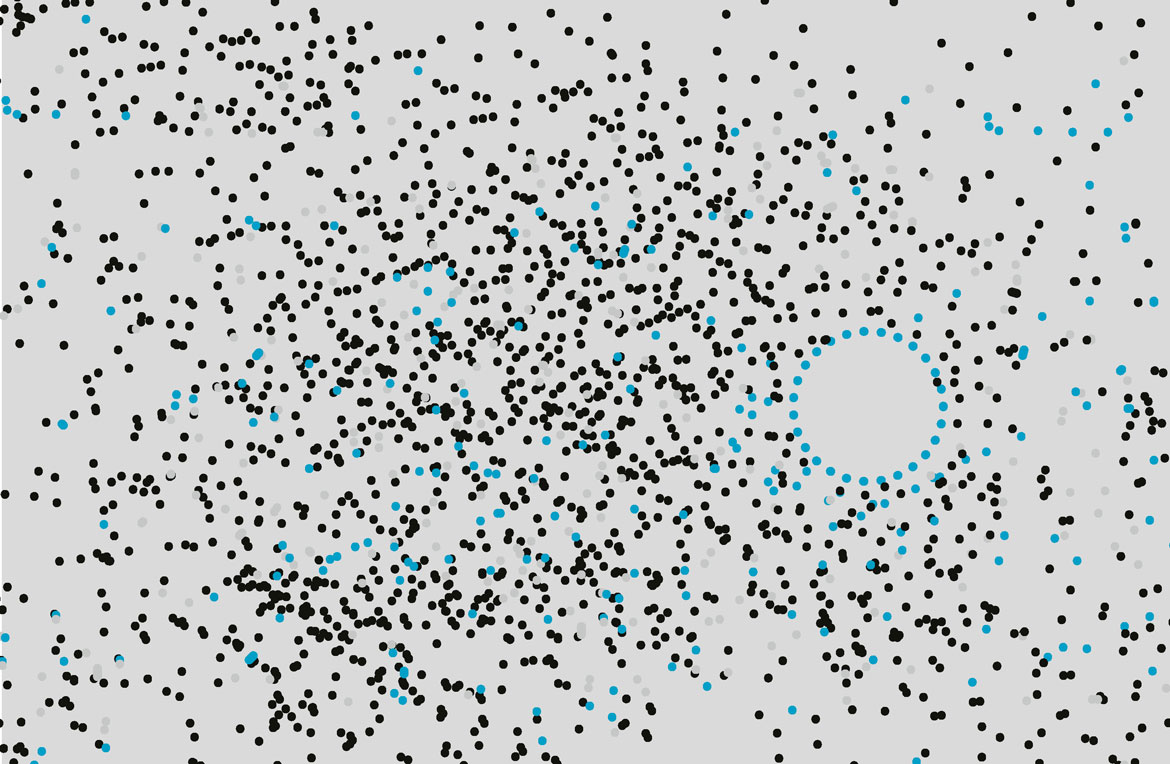

Forschende um Steven Schramm von der Universität Genf glauben Hinweise auf unentdeckte Teilchen in den reichlich am LHC produzierten Kollisionen im Niedrigenergiebereich finden zu können. Sie wollen das sogenannte Rauschen der Daten untersuchen, das etwa durch sich überlagernde Signale, Messungenauigkeiten und Fehler der Geräte entsteht. Dieses soll mit Hilfe von KI in echte Daten verwandelt werden, um darin Muster zu erkennen. Ein solches Muster könnte auf ein Teilchen hindeuten, das den Ursprung der dunklen Materie erklärt. «Wir hoffen, eine neue Physik zu finden», sagt Schramm. Nur mit Hilfe der KI sei es möglich, die Riesenmengen an Daten aus den LHC-Detektoren zu verarbeiten. Insgesamt ist die Aufgabe anspruchsvoll, geht es doch darum, ein 3D-Bild der elektrischen Signale aus einer Teilchenkollision zu verstehen.

Die Forschenden verwenden dafür sogenannte Graph-neuronale Netze. Trainiert wird das System mit Simulationen aus dem Standardmodell der Teilchenphysik. Damit lernt es, normale Ereignisse zu erkennen. Danach soll die KI im realen Kollisionsrauschen Abweichungen finden, also Hinweise auf eine eventuelle neue Physik. Gleichzeitig muss sie erwartete Anomalien, also Fehler eines LHC-Detektors, ausschliessen.

«Die Suche nach Anomalien mit Hilfe der KI ist ein völlig neuer Ansatz», erklärt Schramm. «Er ermöglicht, effizient nach Phänomenen zu suchen, die von der Theorie nicht vorhergesagt wurden.» Und wenn die Suche fehlschlägt? Dann habe man zumindest schneller Sicherheit, dass sich in den untersuchten Energiebereichen keine neue Physik verberge.

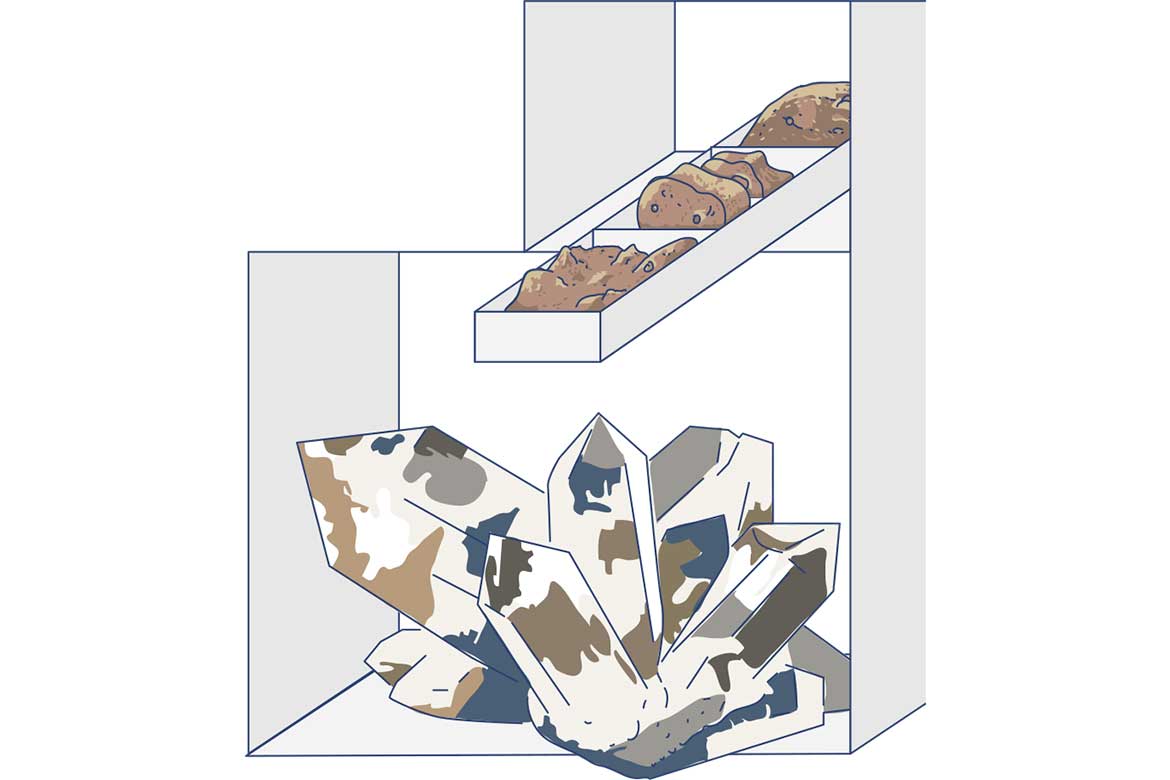

Damit das Medikament besser in die Zelle dringt

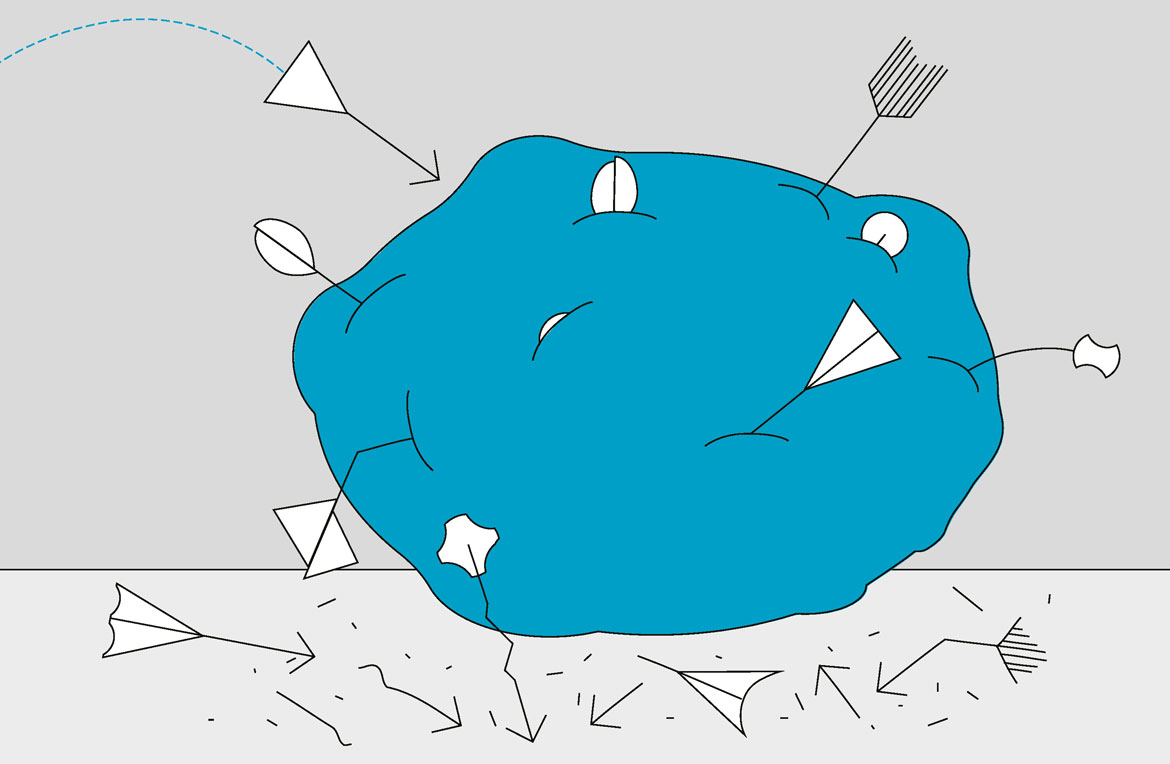

Eine der grössten Herausforderungen bei der Entwicklung neuartiger Arzneimittel ist es, die therapeutisch wirksamen Moleküle zielgerichtet an ihren Bestimmungsort zu bringen, vor allem wenn die Zielstrukturen im Inneren von Zellen liegen. Jede Zelle ist von einer Grenzschicht umgeben, einer schützenden Biomembran, die zugleich den Kontakt zur Aussenwelt vermittelt. Es ist daher enorm wichtig, das Verhalten sogenannter zelldurchdringender Peptide zu verstehen. Die kurzen Aminosäuresequenzen können die Zellmembran überwinden und Moleküle in die Zellen schleusen. «Das hat grosses Potenzial für künftige gezielte Arzneimittelgabe», sagt Gianvito Grasso vom IDSIA.

Da herkömmliche Methoden, das Verhalten dieser Peptide vorherzusagen, entweder sehr rechenaufwendige Modelle erforderten oder experimentell anspruchsvoll waren, setzt das Team am IDSIA auf künstliche Intelligenz. Algorithmen lernen, bestehende grosse Datenbanken mit bekannten zelldurchdringenden Peptiden zu analysieren und neue Peptide mit ähnlichen Eigenschaften zu identifizieren.

Trainiert wurde das System mit Daten aus der wissenschaftlichen Literatur zu zelldurchdringenden und anderen Peptiden. Diese enthalten Informationen wie die Peptidsequenz, biophysikalische Eigenschaften und ihre Fähigkeit, Zellmembranen zu durchdringen. Das System für maschninelles Lernen des IDSIA nutzte dann diesen Datensatz, indem es die Aminosäuresequenzen bekannter Peptide beider Arten analysierte, um Strukturen zu identifizieren, die mit dem leichteren Eindringen der Peptide in die Zellen in Verbindung stehen.

Ziel war es, die Fähigkeit verschiedener Peptide, Zellmembranen zu durchdringen, genau vorherzusagen. Der Algorithmus kann aber nicht nur das Verhalten von Peptiden vorhersagen, sondern schlägt auch Modifikationen an der Peptidsequenz vor, damit diese leichter in eine Zelle eindringen, wie Grasso erklärt. Das Tool soll helfen, Peptide vor deren Synthese einfacher einzuschätzen.

Uralte Handschriften unter digitaler Lupe

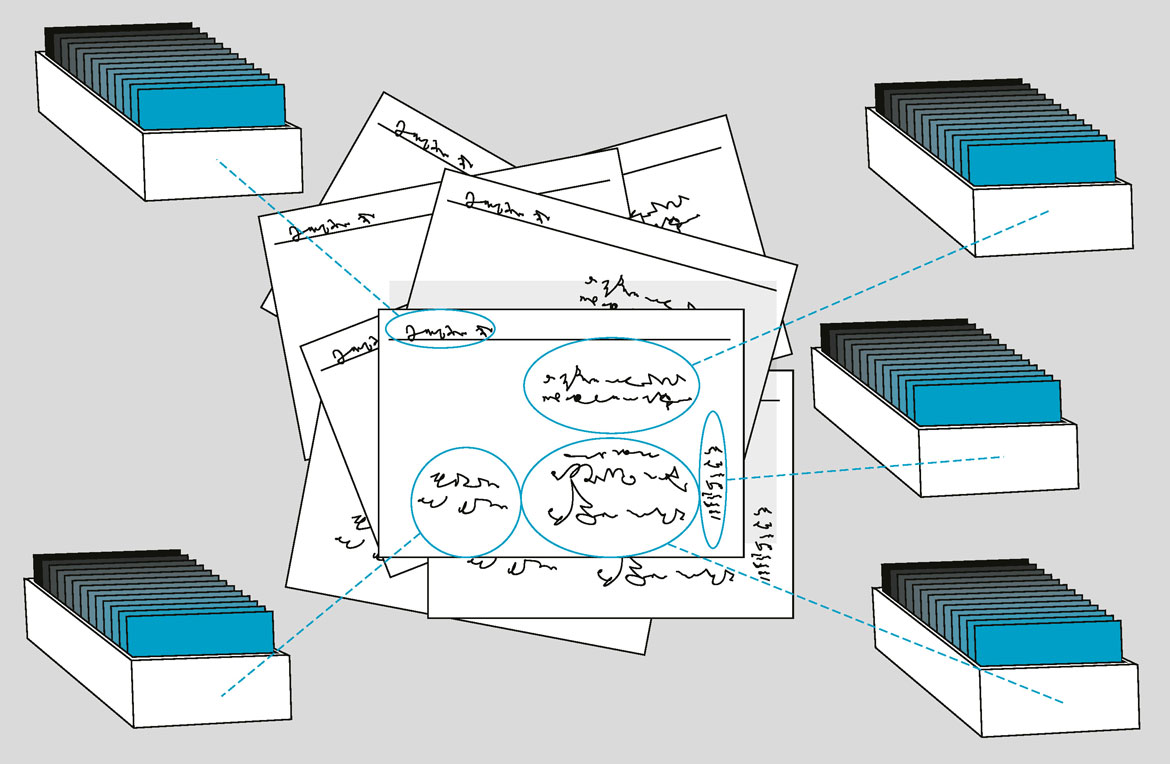

Das Historische Grundbuch der Stadt Basel umfasst mehr als 220 000 Karteikarten, mit Informationen zur städtischen Bausubstanz, die bis ins 12. Jahrhundert zurückreichen. «Für Geschichtsforschende ist so ein Bestand von immensem Wert», sagt Lucas Burkart von der Universität Basel. Allerdings sind die Notizen handgeschrieben. Um die Karteikarten für historische Forschungsfragen zugänglicher zu machen, setzen Burkart und sein Kollege Tobias Hodel von der Universität Bern nun auf KI-basierte Erschliessungsmethoden.

Ziel ist es, die Karten zu erfassen und für einen Zeitraum von 300 Jahren (1400–1700) auszuwerten. So wollen die Forschenden alle Begriffe, Vorgaben und üblichen Vorgehensweisen im Umgang mit dem städtischen Grundbesitz in Basel verstehen und damit auch den Wandel im Immobilienhandel analysieren, sowohl in Einzelfällen wie etwa dem Kloster Klingental als auch für den gesamten Stadtraum.

Die Forschenden nutzen dafür verschiedene Verfahren des maschinellen Lernens wie etwa sprachliche Datenverarbeitung. Zunächst verortet das System Textregionen auf der Registerkarte räumlich. Im zweiten Schritt geht es darum, die Handschriften selbst zu lesen, also die Worte in der jeweiligen Sprache und den Schriftarten (Latein, alte deutsche Formen) korrekt zu erfassen. Der dritte Schritt ist der auf-wendigste: «Hier zerlegen wir jede Karte in sogenannte Events», sagt Hodel. Unter einem Event verstehe man dabei eine Handlung wie ein Kauf, ein Verkauf oder eine Pfändung, an der jeweils bestimmte Personen oder Institutionen wie Klöster beteiligt seien.

«Solche Events sind nicht immer eindeutig und entsprechen bisweilen einer historischen Eigenlogik, die nicht unmittelbar verständlich ist», sagt Burkart. «Hinter einem Begriff wie Zins etwa verbergen sich verschiedene Formen ökonomischer Transaktionen.» Das Projekt verfolgt auch ein übergeordnetes Ziel. «Wir versuchen, die Fehlerquote bei einzelnen Schritten der maschinellen Auswertung, etwa der Erfassung der Handschriften, zu messen», erklärt Hodel. Es gehe dabei generell um die Belastbarkeit der mit KI-Methoden gewonnenen Resultate. Solche Analysen des Systems müssten «Teil der methodischen Weiterentwicklung der Geschichtswissenschaften werden».

Vor lauter Bäumen den Klimawandel sehen

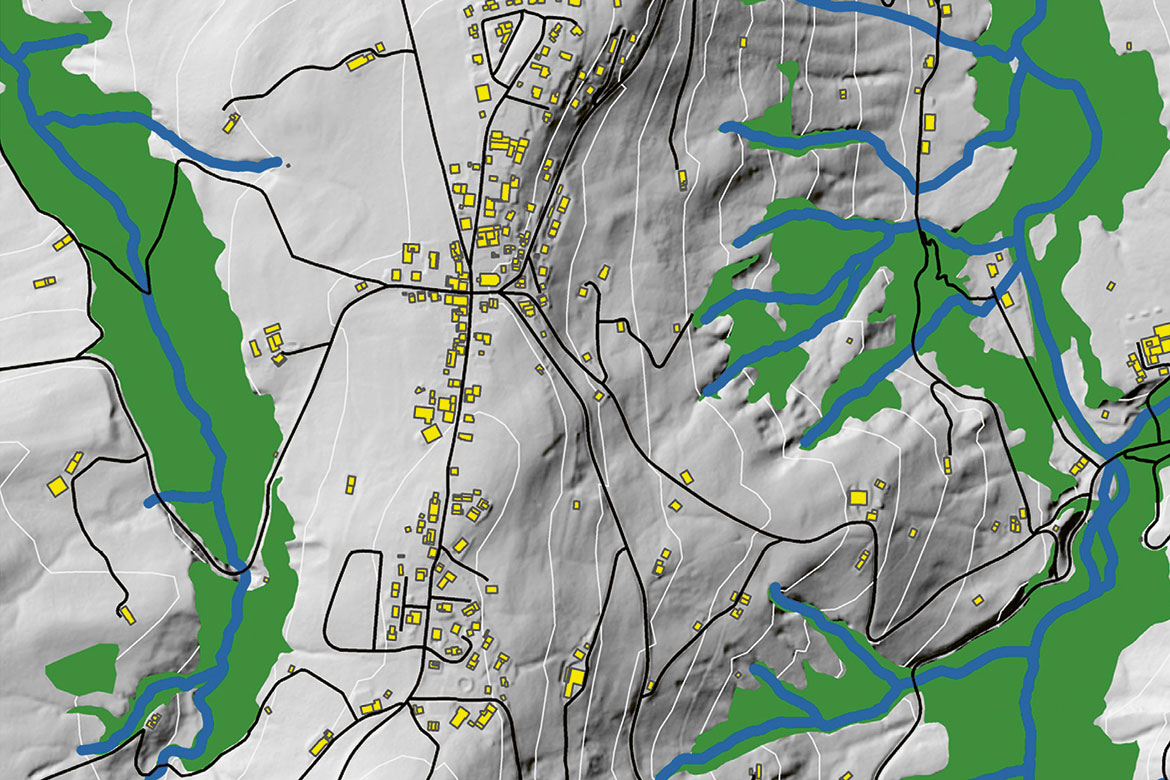

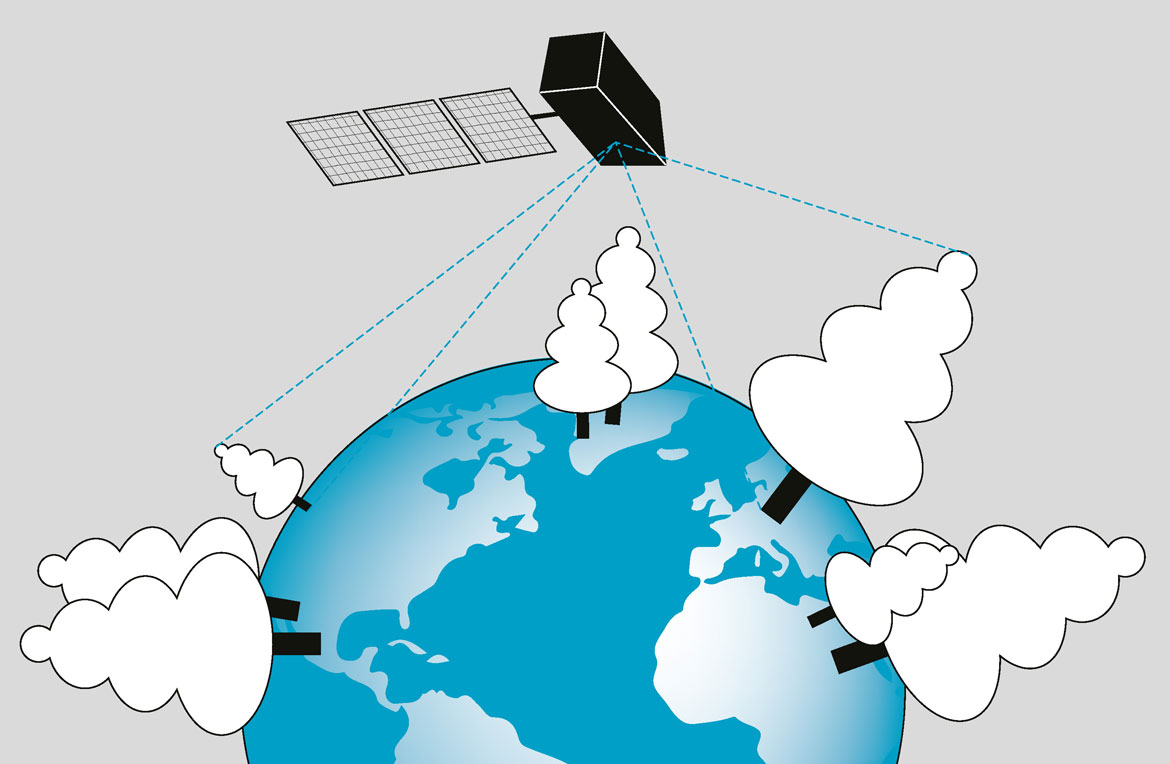

Die Höhe eines Baums zu vermessen, erscheint auf den ersten Blick keine Aufgabe, für die es eine künstliche Intelligenz bräuchte. Aber Konrad Schindler will auch nicht einen, sondern alle Bäume der Erde erfassen. Solche Daten sind von extrem hoher Bedeutung, denn sie erlauben es, mit Hilfe von Modellen die Verteilung der Biomasse auf der Erde zu bestimmen und damit auch der in der Vegetation gespeicherte Kohlenstoff.

«Wir sind dabei die Kartenmacher für die Vegetationshöhen», sagt der Zürcher Geodät und Computerwissenschaftler. Ihn interessiert, wie man mit Hilfe von KI-Methoden umweltrelevante Grössen und Zusammenhänge wie etwa die Vegetationsdichte automatisiert kartieren kann, für die das bislang nicht so gut möglich war. «Unsere Technologie erlaubt es, sogar hohe Bäume korrekt zu vermessen, die hinsichtlich Biodiversität und Biomasse besonders wichtig sind», sagt Schindler.

Die Methode ist aufwendig, denn Schindler verwendet für sein System als Trainingsdaten Pixelbilder von Kameras der beiden ESA-Satelliten Sentinel 2A und 2B. Als Referenzdaten für das Training dienen Messwerte von Baumhöhen des Laserscanners GEDI, den die Nasa an die Weltraumstation ISS montiert hat. Von dort wurden bislang Hunderte Millionen Einzelmessungen gemacht.

Da der Zusammenhang zwischen den Informationen in den Pixeln und Baumhöhen zu kompliziert ist, um daraus ein physikalisches Modell erstellen zu können, setzt Schindler auf maschinelles Lernen. Das System basiert auf einem sogenannten tiefen neuronalen Netz, das auch in der Lage ist, die statistische Unsicherheit der Ergebnisse, also eine Art Ungenauigkeit, anzugeben. Forschende nennen das «probabilistic deep learning».

Die Karte könnte in Zukunft wichtige Hinweise für geeignete Massnahmen im Kampf gegen den Klimawandel und das Artensterben liefern. Sie liesse sich etwa für das Monitoring bestimmter Waldregionen oder Schutzgebiete einsetzen. Hierzulande laufen bereits Gespräche mit der Eidgenössischen Forschungsanstalt für Wald, Schnee und Landschaft WSL.

Ordnung ins Chaos der Gesundheitsdaten

Ältere Menschen leiden häufiger unter Nebenwirkungen von Medikamenten und sind anfälliger für unerwünschte Wechselwirkungen verschiedener Wirkstoffe. Ein Team des IDSIA in Lugano entwickelte daher eine KI, die automatisiert elektronische Patientendossiers älterer Menschen in Spitälern analysiert, um mögliche Komplikationen früh zu entdecken.

Die verwendeten Daten sind für eine KI komplex. Patientinnendossiers enthalten nämlich oft grosse Textmengen, in der Schweiz notieren Ärzte ihre Beobachtungen und Diagnosen zudem in den verschiedenen Landessprachen. Die Daten aus den Akten sind ausserdem sehr unstrukturiert. Um relevante Informationen daraus zu extrahieren, setzte das IDSIA-Team um Fabio Rinaldi daher sowohl auf die Technik der sprachlichen Datenverarbeitung, die auch in aktuell intensiv diskutierten Systemen wie Chat-GPT zum Einsatz kommt, als auch auf sogenanntes Text-Mining. Ziel war, dass die KI unerwünschte Ereignisse und ihre Auslöser erkennt.

Konkret ging es im Projekt um die Nebenwirkungen von Anti-Thrombose-Mitteln. Zur Qualitätskontrolle nutzte die KI Erkenntnisse zu Wechselwirkungen verschiedener Medikamente aus vier an der Studie beteiligten Schweizer Spitälern.

Ein wichtiges Thema beim Umgang mit Trainingsdaten von Patientinnen und Patienten ist die Anonymität. Das IDSIA-Team musste zunächst sämtliche Patientendossiers mit Hilfe geeigneter Tools der sprachlichen Datenverarbeitung anonymisieren. Diese Anonymisierung klinischer Berichte habe grosses Potenzial, sagt Rinaldi, auch über sein eigenes Projekt hinaus. «Wir wollten wertvolle medizinische Informationen für wissenschaftliche Zwecke nutzbar machen.» Generell könnten gesundheitsrelevante Daten, wenn sie in grossem Umfang zusammengeführt werden, medizinische Erkenntnisse zutage fördern, die bei einer isolierten Betrachtung von nur wenigen Fällen nicht sichtbar seien.