Fokus: Forschungspartnerin KI

Maschine, schreib mir das schnell!

Ob Publikationen oder studentische Arbeiten, in der Wissenschaft gibt es zunehmend Texte, die mit Hilfe von Künstlicher Intelligenz entstanden sind. Meinungen zum Umgang damit gehen auseinander.

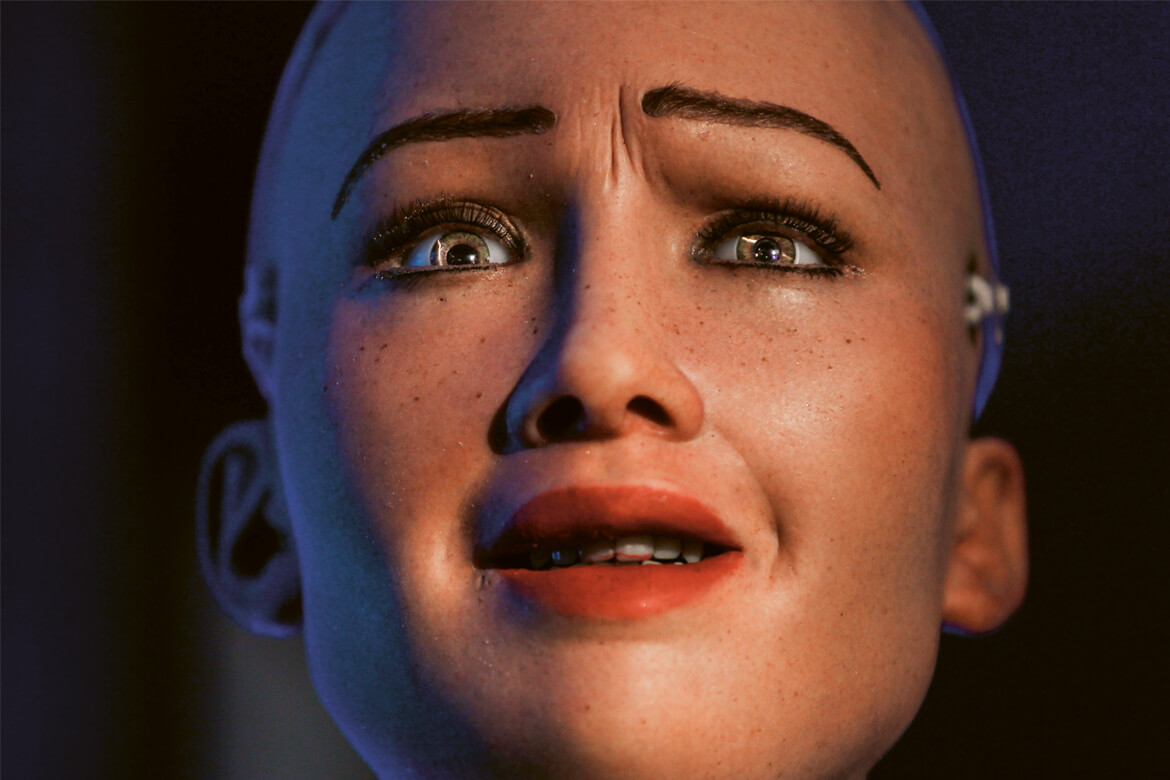

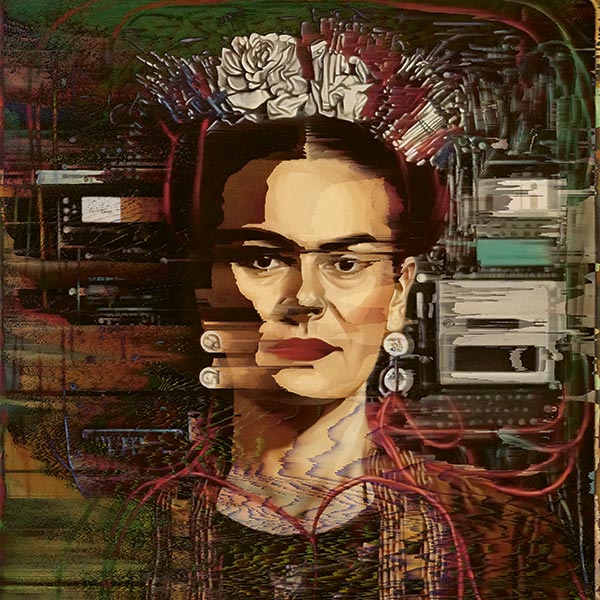

John William Waterhouse’ Bild «Echo und Narcissus» von 1903 wurde mittels Algorithmen und Mensch an heute angepasst. Was wenn auch Forschende die klugen Programme zur Mitschöpferin machen? | Bilder: Jonas Wyssen

Das kluge Textprogramm Chat-GPT hat seit einigen Monaten Hochkonjunktur, unter anderem weil es von der Firma Open AI kostenlos zugänglich gemacht wurde. Auch im akademischen Bereich eröffnen sich damit ganz neue Möglichkeiten, wobei die Resultate erstaunlich gut sind: beim Recherchieren, Schreiben und Reviewen – oder auch beim Betrügen. Die Wissenschaftszeitschrift Nature jedenfalls hat bereits Regeln für den Umgang mit KI erlassen. Unter anderem muss von den Autoren und Autorinnen die Herkunft einer maschinell entstandenen Aussage transparent dargelegt werden.

Der Wissenschaftshistoriker Mathias Grote von der Universität Bielefeld diagnostiziert einen Zeitpunkt des Wandels: «Es scheint einer jener Momente erreicht, die vor allem in der Nutzung einen Durchbruch darstellen.» Vergleichbare Zeitpunkte habe es beim Internet, bei der Suchmaschine von Google oder beim Smartphone gegeben. Dass sich KI dereinst durchsetzen werde, habe sich seit geraumer Zeit angekündigt.

Grote erinnert sich an Debatten Anfang der 2000er-Jahre: «Damals ging es noch mehr um eine kategorische Klärung und um eine theoretische Diskussion.» Darum also, was künstliche Intelligenz eigentlich ist. Heute dagegen steht die Technologie selbst im Vordergrund. Und natürlich spielen ökonomische und politische Motive bei der Entwicklung eine wichtige Rolle: Datenkonzerne und Grossverlage etwa würden mit den Textprogrammen monetäre Interessen verfolgen.

Ende des selbstständigen Denkens?

Was seit Chat-GPT-4 für alle zugänglich ist, wird auch beim Verfassen von wissenschaftlichen Texten verwendet. Entsetzt und erschüttert über die neuen Werkzeuge, die «Internet-Unternehmen den Studierenden und Forschenden zur Verfügung stellen», zeigt sich Kardiologe Matthias Barton von der Universität Zürich. Er ist Mitherausgeber der Open-Access-Fachzeitschrift für Biomedizin und Biowissenschaften E-Life. «Es ist nicht ganz klar, wer hinter diesen Programmen steckt», erklärt er. Zudem würden diese mit sehr fragwürdigen Aussagen beworben wie zum Beispiel, dass künstliche Intelligenz es einem Computer ermögliche, ohne menschliches Zutun wie ein Mensch zu denken.

KI sei überhaupt ein falscher Begriff, findet er, spricht sogar von einem Etikettenschwindel. Von Intelligenz könne keine Rede sein, es gehe ganz banal um den Einsatz von Algorithmen, insbesondere im Publikationssystem. Grundsätzlich finde dort eine Entpersonalisierung statt, sagt Barton. Und das selbstständige Denken rücke in den Hintergrund. «Dieser Umstand führt dazu, dass Studierende und junge Wissenschaftler, die wissensmässig in ihrem Fachgebiet noch am Anfang stehen, wissenschaftliche Arbeiten oder Teile davon mit KI erstellen können, jedoch ihren eigenen Namen als Autor angeben.»

Um dieser neuen Form des Betrügens bereits im Studium beizukommen, braucht es auch neue Herangehensweisen. Dozierende müssten den Studierenden das Ethos der Selbstkontrolle vermitteln, schlägt der St. Galler Wissenschaftshistoriker Caspar Hirschi vor. Für eine eigentliche Überprüfung von studentischen Arbeiten brauche es nämlich starke Verdachtsmomente wie etwa grosse Unterschiede bei der Sprachfertigkeit innerhalb einer Arbeit. Mehr Überprüfung wäre allein wegen der schieren Anzahl zu kontrollierender Texte kaum machbar. «Gegenseitiges Vertrauen ist wichtig», ist Hirschi deswegen überzeugt, «verbunden mit dem Einfordern von Selbstdeklarationen, wie das Nature macht.»

Gegen das Betrügen in Fachzeitschriften reicht das wohl nicht. Matthias Barton plädiert für Richtlinien. «Aktiv werden müssten die Schweizerischen Akademien der Wissenschaften, besonders in der Medizin – und zwar schnell.» Er schlägt vor, dass alle Autorinnen schriftlich bestätigen müssen, dass sie keine KI verwendet haben. Für Hirschi ist das zwar auch vorstellbar, er sieht darin aber keinen Gamechanger. «Das System der modernen Wissenschaft basiert auf einem geschulten Vertrauen in die seriöse Arbeit von anderen», erklärt er. In der experimentellen Forschung sei das immer so gewesen. Die Wissenschaft habe ihre Kontrollmechanismen nie flächendeckend anwenden können. Sonst wäre das System kollabiert.

Verbote wohl kontraproduktiv

Ähnliche Probleme kennt die Forschung ja eigentlich schon länger, nämlich von Arbeiten, die von Ghostwriterinnen geschrieben wurden. Und vom Kampf gegen Plagiate. In Zeiten von KI-Programmen sei es besonders wichtig, eine originäre Denkleistung einzufordern, ist Wissenschaftshistoriker Mathias Grote dennoch überzeugt. Allenfalls wäre ein digitales Wasserzeichen ein Teil der Problemlösung, also eine technische Markierung in Texten zur Nachverfolgung von Quellen. Um Fälschungen, die mit der Unterstützung von KI entstanden sind, zu erkennen, müsse aber auch schlicht der wissenschaftliche Umgang mit ihr geübt werden, was Teil der studentischen Ausbildung werden müsse. Verbote erachtet Grote dagegen als kontraproduktiv.

Die Anwendung von KI in wissenschaftlichen Publikationen wirft aber auch Fragen jenseits ihrer Deklarierung auf. Ein Abstract zu verfassen etwa – und hier werden kluge Textprogramme schon häufig eingesetzt – ist laut Matthias Barton eigentlich Teil eines Prozesses, um wissenschaftliches Schreiben zu lernen. Diese Lernerfahrung geht mit dem Einsatz von KI verloren.

Grundsätzlich leiste eine Publikation einen kleinen Beitrag zum Stand des Wissens, um die Wissenschaft als Ganzes weiterzubringen. «Aber es besteht ein grosser Druck zum Publizieren, der von den Universitäten ausgeht, dieser kommt den Verlagen äusserst gelegen.» Und er habe zur Folge, dass auch Doktorierende und Postdocs dazu verleitet werden können, mit KI-Programmen zu arbeiten, statt selbstständig Arbeiten anderer Wissenschaftler zu lesen und so auch das wissenschaftliche Schreiben zu lernen.

«Leider geschieht dies häufig in der Medizin», sagt Barton. «Ich weiss von maschinellen Übersetzungen durch die KI Deepl, die eins zu eins in Manuskripte hineinkopiert wurden, was natürlich nicht angegeben wurde.» Auch hier fehle es an nötigen Regulierungen, wie sie kürzlich der deutsche Ethikrat oder verschiedene britische Universitäten erlassen haben. «Denn der Mensch ist von Natur aus bequem und nutzt, was ihm zur Verfügung steht.»

Standardargumente ohne Originalität

Caspar Hirschi findet: «Man kann mit KI einen Text schreiben lassen, der gar nicht so schlecht ist.» Die Standardargumente bringe sie zusammen, vergleichbar mit Wikipedia. Aber ein solcher Text bilde nur einen Wissensstand ab, sei nicht immer referenziert und bar jeder Originalität. Darüber hinaus seien eine Forschungsleistung und die Herstellung von Zusammenhängen nicht möglich. Neues methodisches Vorgehen sei von der Forschung zu leisten und könne nicht an eine KI delegiert werden. «Dadurch wird die Kluft zwischen neuer Forschung und einfachem Zusammenfassen grösser.»

Mathias Grote beurteilt das Vermögen von KI ähnlich. Mit ihr seien Gebrauchstexte zwar schnell und effektiv zu erstellen und Recherchen durchzuführen. «Das meiste stimmt, wenn sich das Programm auf hinlänglich bekannte und verfügbare Fakten abstützen kann, aber eben doch nicht alles.»

Deshalb müssten solche Texte zwingend weiterbearbeitet, überarbeitet und korrigiert werden und könnten höchstens als Grundlage dienen. «Ich kann mir schwerlich vorstellen, dass genuine wissenschaftliche Entdeckungen jemals nur von einer KI gemacht werden.» KI sei vielmehr als sinnvolles Hilfsmittel einzusetzen, um Standardinformationen schnell abrufen und Routinen sowie Berechnungen durchführen zu können – ähnlich wie es früher Handbuch, Tabellen und Taschenrechner waren.

Bei aller Kritik an der Verwendung von KI-Programmen ortet auch Matthias Barton hier Chancen. «Wenn der Algorithmus gut programmiert ist, lassen sich Recherchen an die KI delegieren, was Zeit und Aufwand spart», führt er aus. Doch die gelieferten Ergebnisse müssten zwingend geprüft werden, sonst überwiege die Gefahr. In der Medizin könne KI in beschränktem Mass bei der Erfassung und Verarbeitung von grossen Datenmengen von Vorteil sein. Wenn aber in Forschungsanträgen die Verwendung von KI explizit aufgeführt werde, nur weil sie gerade en vogue sei, dann stimme etwas nicht. «Besser wäre es, einmal innezuhalten und zu überlegen, ob von einem Fortschritt gesprochen werden kann.»

KI kann Stress mildern

Auch im Peer-Review-Prozess von Fachzeitschriften wird KI bereits verwendet. Der Mitherausgeber von E-Life, Matthias Barton, sieht sie als nicht geeignet dafür an, da KI nicht über Fachwissen verfüge. Auch könne sie die inhaltliche Relevanz der in wissenschaftlichen Arbeiten zitierten Literaturstellen gar nicht bewerten. Bei E-Life kämen grundsätzlich nur ausgewiesene Fachleute als Gutachtende in Betracht.

Trotzdem seien solche Programme beim Peer-Review als Hilfsmittel bereits weit verbreitet. Sie werden von vielen Verlagen verwendet, um etwa Editoren mögliche Gutachter vorzuschlagen. «Sie sind froh, wenn sie überhaupt welche finden.» Doch auch sonst im Peer-Review-Prozess wird auf KI gesetzt. Denn selbst wenn eine Gutachterin gefunden ist, ist sie in der Regel überlastet und muss sich die Zeit zwischen regulärer Arbeit und Begutachtung aufteilen. KI kann zum Beispiel diesen Stress mildern, indem sie ihr auf der Grundlage ihrer früheren Arbeiten, Kommentare und Interaktionen Vorschläge unterbreitet. Das zumindest versprechen Anbieter solcher Programme.

Dass Unternehmen wie der Elsevier-Verlag oder Online- Publisher wie MDPI im Peer-Review auf KI setzen, überrascht Barton nicht. «Der Publishing-Prozess ist von vielen Firmen längst in Länder wie China, Indien oder Pakistan ausgelagert worden.» Durch äusserst billige Arbeitskräfte sparten die Verlage enorme Kosten, reduzierten aber gleichzeitig auch die Verantwortung für den Inhalt der von ihnen veröffentlichten Zeitschriften. Je offener das System sei, desto anfälliger sei es. Jeder Algorithmus habe naturgemäss seine Grenzen und Ungenauigkeiten, die dann in den wissenschaftlichen Prozess einflössen.