Fokus: Forschung aus Betroffenheit

Wahrheit nach Vorschrift

Vom Alchemisten im Fürstenhof bis zur doppelblinden Studie: Die Geschichte der wissenschaftlichen Methode ist eine von Chaos und Kontrolle. Ein Rückblick in vier Teilen.

1575 wurde Philipp Sömmering hingerichtet. Ihm war es jahrelang nicht gelungen, Gold herzustellen. Dabei hatte er sich mit der Behauptung, das Edelmetall aus weniger edlen Stoffen erschaffen zu können, einen lukrativen Job und ein gut ausgestattetes Labor am Fürstenhof Braunschweig-Wolfenbüttel gesichert.

Sömmering war Alchemist. Heute würde er als Pseudowissenschaftler gelten. Damals aber war sein magisches Wissen begehrt. «Es war eine aufregende Zeit», sagt der Wissenschaftshistoriker Ion-Gabriel Mihailescu von der Universität Neuenburg. «Auf der einen Seite stand die über Jahrhunderte etablierte Naturphilosophie der Universitäten. Sie bot ein stimmiges Weltbild, das alles erklären konnte – von der Bewegung der Sterne bis hin zum Verhalten der Materie auf der Erde.» Auf der anderen Seite standen Alchemisten wie Sömmering, aber auch Künstler oder Handwerker und stellten wilde Behauptungen auf, die dem Weltbild der Universität widersprachen. «Sie gaben vor, die Natur manipulieren zu können, weil sie geheime Wahrheiten entdeckt hätten. Ja, man könnte sagen: Damals herrschte intellektuelles Chaos», sagt Mihailescu.

Und das warf Fragen auf: Wie entsteht verlässliches Wissen? Und wie lässt es sich überprüfen? Eine Antwort darauf gab die wissenschaftliche Revolution. Das war eine Entwicklung, die im 16. Jahrhundert begann und den Gedanken hervorbrachte, dass Wissen von den Verfahren unabhängig sein sollte, mit denen es gewonnen wurde. Die wissenschaftlichen Methoden wurden entwickelt. Vier Beispiele und wie sie die Forschung verändert haben.

Illustration: Bunterhund

Durch andere überprüft und bestätigt

Die Royal Society spielte eine wichtige Rolle dabei, wie fortan wissenschaftliche Erkenntnisse gewonnen und überprüft wurden. Gegründet 1660 in London, war sie von den empirischen Idealen des «Novum Organum» von Francis Bacon geprägt – eines der ersten methodischen Werke der Wissenschaftsgeschichte. Zwar legte Bacon kein penibles Protokoll vor, aber sein Fokus lag auf systematischer Beobachtung und praktischer Forschung, die das Experiment zum Mittel der Wahl machte. Ein Beispiel dafür zeigt das Ölgemälde «Das Experiment mit dem Vogel in der Luftpumpe» von Joseph Wright of Derby. Es stellt ein reales Experiment von Robert Boyle, einem der Gründer der Society, nach. Darauf zu sehen sind Männer, Frauen und Kinder, die um eine verschliessbare Glaskugel mit einem weissen Kakadu herumstehen, während die Luft aus dem Gefäss gesaugt wird. Die Frage des Experiments: Ist Luft für das Leben notwendig?

«Die Royal Society führte gemeinsam Experimente durch, um Wissen zu erzeugen», sagt Mihailescu. «Ebenso wichtig aber war, dass die Experimente von anderen Mitgliedern der Gesellschaft bezeugt und überprüft wurden.» So habe der Historiker Steven Shapin gezeigt, dass zu dieser Zeit die Glaubwürdigkeit wissenschaftlicher Aussagen davon abhing, wer sie beobachtet habe. «Deshalb waren die Mitglieder der Society Gentlemen – finanziell unabhängig und damit in den Augen der Öffentlichkeit glaubwürdig», erklärt Mihailescu. Die Royal Society schuf zudem Wege, wissenschaftliche Erkenntnisse zu verbreiten – insbesondere durch ihr Journal Philosophical Transactions. Weil darin aber meist nur die Ergebnisse eines Experiments mitgeteilt wurden, brachte das mehr Probleme als Konsens. Denn: Damals gab es noch keine einheitlichen Standards.

Das zeigt das berühmte Licht-Experiment Isaac Newtons. Er hatte weisses Licht durch ein Glasprisma geleitet und in sein Farbspektrum zerlegt. Weisses Licht, schlussfolgerte Newton, enthält farbiges. Aber andere europäische Wissenschaftler scheiterten reihenweise daran, sein Ergebnis zu reproduzieren. Newton warf ihnen deshalb vor, dies läge an «falschen» Prismen, was ihm wiederum den Vorwurf einbrachte, er definiere «richtige Prismen» nur als jene, die seine Ergebnisse bestätigten. Später stellte sich heraus, dass alle anderen venezianisches Glas benutzt hatten. Auch wenn es kunstvoll gearbeitet ist, eignet es sich nicht für optische Experimente.

Die Idee, dass eine Behauptung von einer Community überprüft und bestätigt wird, ist heute Grundgedanke in der Wissenschaft. Was im 17. Jahrhundert begann, war der Auftakt zu einer langsamen Institutionalisierung und Professionalisierung der Forschung und führte zu einem Paradigmenwechsel darüber, wie sich Erkenntnis durchsetzt.

Illustration: Bunterhund

Systematisch, randomisiert, verblindet

Kaum eine wissenschaftliche Methode hat die medizinische Forschung so tiefgreifend verändert wie die randomisierte kontrollierte Studie – kurz: RCT. Sie ist heute Goldstandard für die Prüfung neuer Therapien. «Ihre Stärke liegt darin, Verzerrungen systematisch auszuschliessen und Aussagen über die Wirksamkeit eines Medikaments zu treffen», erklärt Erik von Elm. Der Arzt und Epidemiologe hat 2011 die Dépendance des internationalen Forschungsnetzwerks Cochrane in der Schweiz mitgegründet. Cochrane fasst seit über 30 Jahren den aktuellen Wissensstand in der Medizin- und Gesundheitsforschung in systematischen Übersichtsarbeiten zusammen. «Die RCT teilt Probanden in eine Experimental- und eine Kontrollgruppe ein», erklärt von Elm. Die Versuchsgruppe erhält ein Medikament, die Kontrollgruppe ein Placebo. Die Überlegung: Zeigen sich nach der Behandlung Unterschiede zwischen den Gruppen, liegt das wahrscheinlich am Medikament. Der faire Vergleich ist das erste Prinzip der RCT.

Ein historisches Beispiel für dieses Vorgehen geht auf den schottischen Arzt James Lind im Jahr 1747 zurück. Während einer monatelangen Schiffsfahrt wollte er erkrankte Matrosen behandeln. Sie alle litten infolge von Vitamin-C-Mangel an Skorbut, was man damals aber nicht wusste. Nur, dass die Krankheit zum Tod führen und dass die Zähne ausfallen konnten – das wohl bekannteste Symptom. Lind suchte systematisch nach einer Behandlung und unterteilte Erkrankte erstmals in Gruppen. Allen verordnete er die gleiche Diät, verabreichte aber zusätzlich jeder Gruppe ein anderes Nahrungsmittel. Nach wenigen Tagen ging es den Matrosen besser, die jeden Tag Zitrusfrüchte – voller Vitamin C – gegessen hatten.

«Das zweite Prinzip der RCT ist die Randomisierung. Das heisst, die Teilnehmenden werden zufällig eingeteilt», fährt Erik von Elm fort. Auf diese Weise sollen die Gruppen vergleichbar sein und es soll beispielsweise eine bewusste Auswahl ausgeschlossen werden. Erstmals wurden Probanden per Losverfahren, also zufällig, bereits im 19. Jahrhundert eingeteilt. «Das dritte Prinzip ist die Verblindung: Idealerweise wissen weder Probanden noch Therapeutinnen, wer das neue Medikament und wer ein Placebo erhält», schliesst von Elm. So werde verhindert, dass sich Therapeuten im Umgang mit Probanden unterschiedlich verhielten, weil sie beispielsweise fürsorglicher mit den Probanden umgingen, die das Medikament erhielten. Erste verblindete Studien gab es schon im frühen 20. Jahrhundert.

Die RCT entstand über Jahrhunderte, ist heute ein elaborierter Methodenmix und hat es zur gesetzlichen Norm geschafft, auch, weil es schwerwiegende Folgen durch unzureichend getestete Medikamente gab. Ein Beispiel dafür ist der Thalidomid-Skandal in den 1950er-Jahren, bei dem das Schlafmittel Contergan bei Tausenden Neugeborenen Fehlbildungen verursachte. Seither müssen Medikamente nicht nur wirksam, sondern auch sicher sein.

Illustration: Bunterhund

Verborgene Muster sichtbar machen

«Ich komme bei der Frage ins Spiel: Wie kann ich aus einem Experiment kausale Effekte erkennen?» – so beschreibt der Statistiker Servan Grüninger seinen Job. Der Forscher der Universität Zürich beschäftigt sich mit experimenteller Versuchsplanung. Ihn interessiert: Wann ist ein beobachteter Effekt das Resultat einer Intervention und wann nicht? Es gibt laut Grüninger eine lange Tradition in der Statistik, «um wissenschaftliche Aussagen auf ihre Verlässlichkeit zu überprüfen». Statistik ist heute Grundlage quantitativer Forschung in nahezu allen Disziplinen und hat das Verständnis von wissenschaftlicher Objektivität grundlegend verändert. «Ein klassisches Beispiel, um die Bedeutung der Statistik zu zeigen, ist das Lady-Tasting-Tea-Experiment», sagt Grüninger. Durchgeführt hat es der Statistiker Ronald Fisher in den 1920er-Jahren: Seine Bekannte Muriel Bristol behauptete – typisch britisch –, sie könne schmecken, ob beim Tee zuerst Milch oder Tee eingeschenkt wurde. Fisher glaubte das nicht und wollte Bristol testen. Er setzte ihr acht zufällig angeordnete Tassen vor. Vier hatte er verdeckt zuerst mit Milch und vier zuerst mit Tee befüllt.

«Jetzt kann ich berechnen, wie wahrscheinlich es ist, dass Bristol zufällig bei allen acht Tassen richtig liegt. Pro Tasse liegt die Wahrscheinlichkeit bei 50 Prozent», erklärt Grüninger. «Acht Mal in Folge richtig zu raten, ist schwierig. Die Wahrscheinlichkeit liegt mit der von Fisher gewählten Versuchsanordnung bei 1,4 Prozent.» Aber genau das geschah: Bristol lag achtmal richtig. Ob man das als Beweis für Bristols Geschmackssinn oder nur als Zufallsergebnis betrachten will, hängt davon ab, ob man 1,4 Prozent als unwahrscheinlich genug betrachtet. Dieser Ansatz lässt sich auf Medikamententests, aber auch auf fast jedes beliebige Studiendesign übertragen. «Die Statistik verbindet dabei Fehlerwahrscheinlichkeit mit Kausalaussagen», fasst Grüninger zusammen.

Eine zweite wichtige Anwendung der Statistik ist es, Muster zu erkennen – «Rauschen von Signal zu trennen», nennt das Grüninger. Was das heisst, zeigt die soziologische Studie «Le Suicide» von Émile Durkheim aus dem Jahr 1897. Was bis dahin als rein individuelles Verhalten galt, wurde durch statistische Methoden übertragbar: Durkheim konnte zeigen, dass Suizidraten mit Faktoren wie Geschlecht, Familienstand und Religionszugehörigkeit korrelieren. Statistik machte sichtbar, was vorher verborgen war. Für das wissenschaftliche Arbeiten war das ein Wendepunkt: Statt Einzelfälle zu deuten, erlaubt Statistik verallgemeinerbare Aussagen. Aber nur, wenn sie richtig eingesetzt wird. Grüninger warnt: «Statistik kann nur nützlich sein, wenn sie in ein Forschungsprogramm eingebettet ist, das klar macht, was wir überhaupt quantifizieren wollen. Ist das nicht definiert, handelt es sich um Pseudowissenschaft.»

Illustration: Bunterhund

Verstehen, nicht beweisen

«Ich arbeite mit Zeugnissen aus der Vergangenheit: mit Texten, Bildern, Artefakten oder auch Landschaftsformen», sagt Dania Achermann. Die Professorin für Wissenschaftsgeschichte forscht und lehrt an der Universität St. Gallen. Ihr Zugang zu Erkenntnis unterscheidet sich grundlegend von den meisten naturwissenschaftlichen Verfahren: «Historische Quellen sind nie neutrale oder objektive Informationsstücke. Dahinter steht immer ein Urheber oder eine Urheberin, es gibt Absichten, ein Zielpublikum.» Achermann arbeitet mit der historischen Methode, in deren Zentrum die Quellenkritik steht. Sie entstand im Zuge der Professionalisierung der Geschichtswissenschaft. Zwar wurde dafür bereits 1759 eine erste Professur geschaffen, sieben Jahre später auch ein Institut, beides in Göttingen, dennoch entstand das Berufsbild des Historikers erst im 19. Jahrhundert.

Seither folgt auch die historische Methode klaren Kriterien, damit historische Zeugnisse nicht unreflektiert übernommen, sondern systematisch hinterfragt werden können: Wer hat die Quelle verfasst? Welche Sprache wird verwendet? Welche alternativen Quellen stehen zur Verfügung – und welche nicht? «Urheber, Adressatin, Sprache, Kontext. Im Studium hakt man alles bewusst ab, später passiert das automatisch», sagt Achermann. Beinahe intuitiv. Deshalb nimmt die historische Methode eine Sonderrolle ein. Oft wird sie in geschichtswissenschaftlichen Arbeiten nicht explizit erwähnt, was Achermanns Zunft mitunter den Vorwurf einbrachte, nicht wissenschaftlich standardisiert zu arbeiten. Selbst aus den eigenen Reihen: Der französische Historiker Marc Bloch sagte einmal, dass die Quellenkritik eine Kunst bleibe, «für die es eines besonderen Fingerspitzengefühls» bedürfe und deshalb kein Rezeptbuch geben könne.

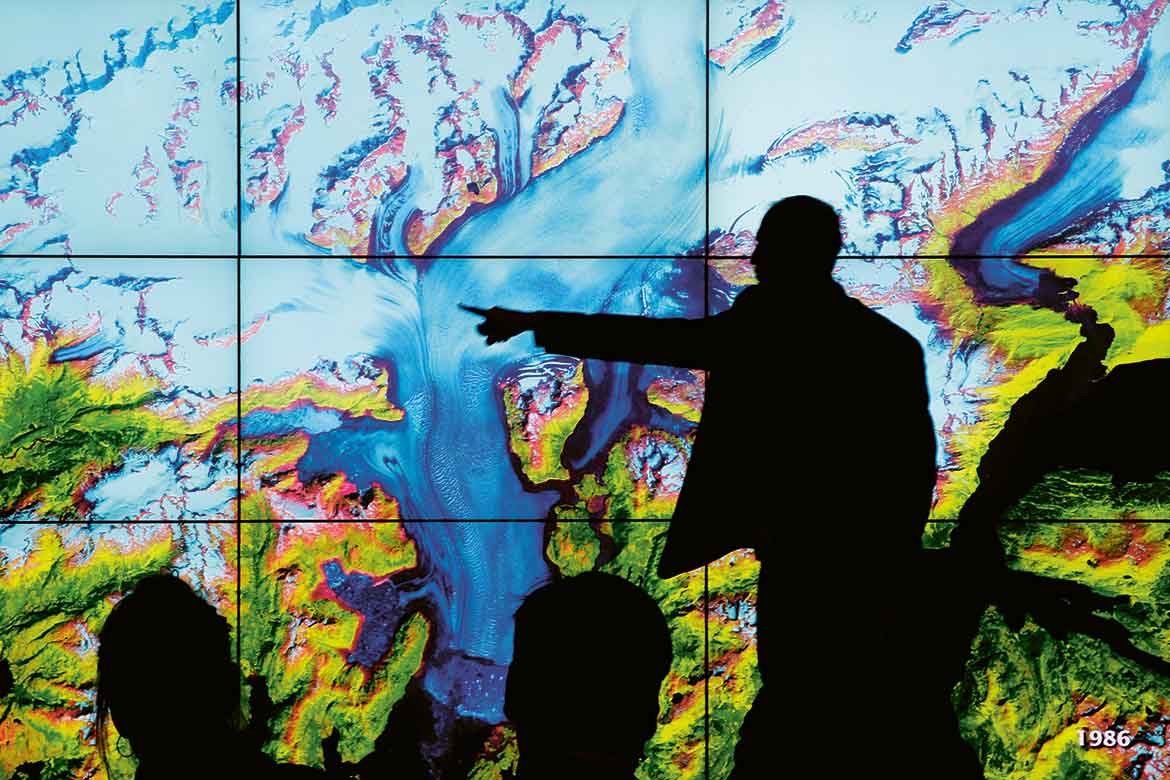

Anders als in quantitativen Untersuchungen geht es nicht darum, Kausalgesetze zu formulieren – sondern Sinnzusammenhänge nachzuvollziehen und Deutungen transparent zu machen. «Mein Ziel ist es nicht, etwas zu beweisen – sondern es zu verstehen, zu rekonstruieren, Absichten zu erkennen», sagt Achermann. Wie das in der Praxis aussieht, zeigt der wissenschaftshistorische Aufsatz «The Image of Objectivity» von Lorraine Daston und Peter Galison. Darin erklären sie, dass sich die Bedeutung von Objektivität im Laufe der Zeit gewandelt – und das auch wissenschaftliche Bilder geprägt habe: Im 18. Jahrhundert galt das sogenannte Typische als objektiv, Interpretation durch Forschende war nicht nur erlaubt, sondern erwünscht: Man nennt es das Truth-to-Nature-Ideal. Im 19. Jahrhundert kehrte sich das um, Status quo war fortan die sogenannte mechanische Objektivität– Kameras und Maschinen sollten Beobachtungen neutral und unverfälscht dokumentieren. Wer, wie Achermann, historische Bilder in wissenschaftlichen Arbeiten analysiert, muss wissen, unter welchem zugrundeliegenden Ideal sie erstellt wurden.

Wissenschaftliche Methoden sind das Ergebnis eines offenen, nie abgeschlossenen Prozesses. Sie garantieren kein endgültiges Wissen und schliessen auch Subjektivität nicht aus – weil diese Teil des wissenschaftlichen Prozesses ist: in der Auswahl der Fragen oder den Interessen der Forschenden beispielsweise. Und auch wenn Methoden wichtig sind, die Stärke der Wissenschaft liegt im kollektiven Abgleich. In ihrer wiederholbaren Anwendung durch viele.