Was, wenn der Chatbot zu Mord anstiftet?

Auch künstliche Intelligenz kann Fehler machen oder gar delinquent werden. Rechtswissenschaftlerinnen haben darüber nachgedacht, wann und wie man Maschinen bestrafen könnte.

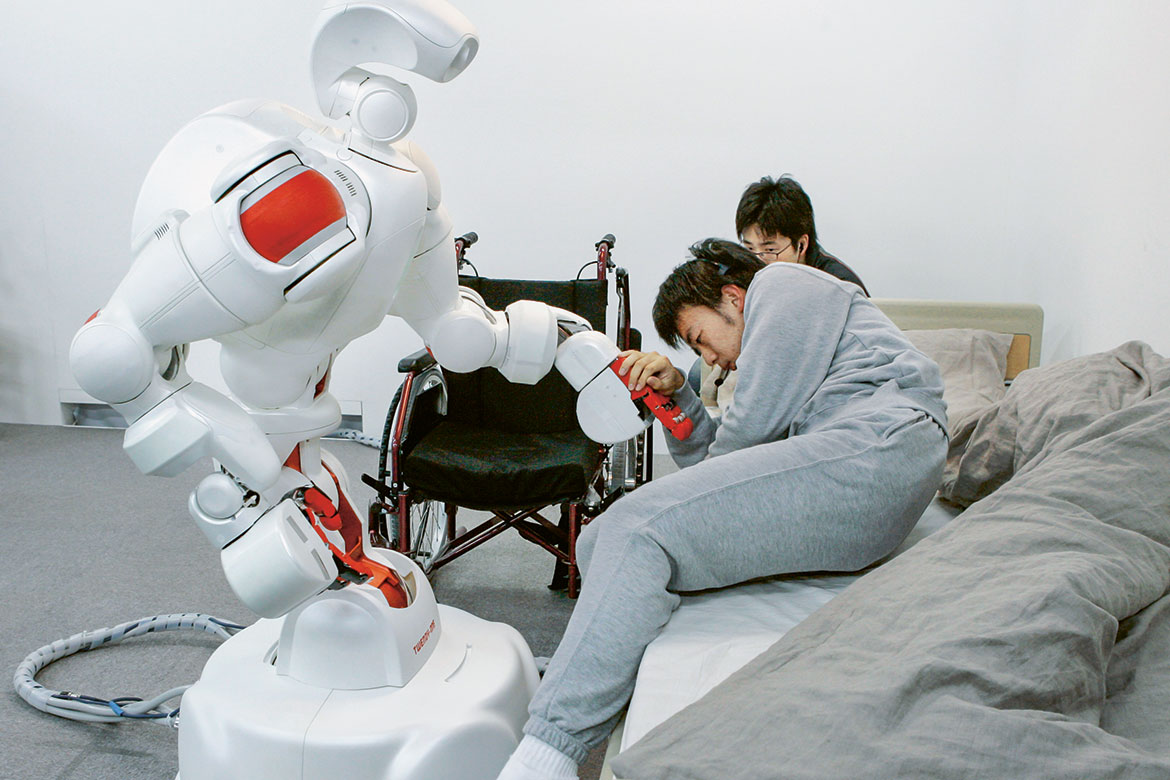

Der Pflegeroboter Twendy-One von der Waseda-Universität in Tokio demonstriert Sicherheit, indem er einem Studenten vom Bett in den Rollstuhl hilft. | Bild: Keystone/AP Photo/Koji Sasahara

Kooperative Maschinen arbeiten Seite an Seite mit Menschen in der Fabrikhalle, Roboter pflegen Patienten im Altersheim und jäten für die Landwirtin Unkraut: Künstliche Intelligenz tritt zunehmend in direkten Kontakt mit Menschen. Dabei kommt es immer wieder zu Unfällen: Beispielsweise erdrückte 2015 ein Roboter in einem deutschen VW-Werk einen Arbeiter. Und bei Crashs mit selbstfahrenden Autos starben bereits mehrere Menschen. «Das ist erst der Anfang», sagt Nora Markwalder, Assistenzprofessorin an der Rechtswissenschaftlichen Fakultät der Universität St. Gallen, die zu neuen Technologien und Strafrecht forscht. Denn autonome Systeme werden selbstständiger und dringen in immer mehr Lebensbereiche ein. Das wirft rechtliche Fragen auf: Wer ist schuld, wenn der Pflegeroboter einen alten Menschen fallen lässt, der Polizeiroboter einen Passanten krankenhausreif schlägt oder der Chatbot zu Mord anstiftet?

Höchststrafe: Verschrotten

«Bisher ist nicht geklärt, wer die Verantwortung trägt, wenn ein Roboter eine Straftat begeht», sagt Markwalder. Gemeinsam mit der Rechtswissenschaftlerin Monika Simmler hat sie sich mit der strafrechtlichen Verantwortlichkeit von Robotern und künstlicher Intelligenz beschäftigt. «Den meisten Menschen erscheint es absurd, einen Roboter zu bestrafen», sagt Markwalder. Im Moment wäre dies rechtlich noch nicht möglich: Die schlauen Maschinen gelten als Sachen und sind deshalb laut Schweizer Gesetz nicht straffähig. Zudem ist künstliche Intelligenz noch nicht so weit entwickelt, dass sie frei entscheidungsfähig ist und für ihr Handeln verantwortlich gemacht werden kann.

«Wenn das in Zukunft der Fall ist, wäre es durchaus sinnvoll, einen Roboter strafrechtlich zur Verantwortung zu ziehen», sagt Markwalder. Nicht unbedingt mit dem Ziel, dass die Maschine sich bessern möge. Aus ihrer Sicht hätte eine Strafe eher den Zweck, die geltenden Normen zu stabilisieren, indem man der Gesellschaft zeigt: Niemand darf ungeahndet töten, auch nicht ein Roboter. Auch zur Art der Strafe haben sich Markwalder und Simmler Gedanken gemacht: Es müsste etwas sein, das der Maschine wehtut. «Das sind natürlich nicht dieselben Dinge wie bei Menschen», sagt Markwalder. Statt den Roboter ins Gefängnis zu stecken, könnte man zum Beispiel seine Rechenkapazität drosseln. Oder ihn verschrotten, als eine Art Todesstrafe. «Das ist alles noch Science-Fiction», sagt Markwalder. Trotzdem findet sie es wichtig, sich rechtzeitig mit Schwierigkeiten auseinanderzusetzen, die früher oder später eintreten könnten.

Zu komplex für Schuld und Sühne

Für die Basler Strafrechtsprofessorin Sabine Gless gibt es momentan allerdings dringendere Fragen. Sie forscht im Nationalen Forschungsprogramm «Big Data» (NFP 75) zur Datensicherheit bei selbstfahrenden Autos. Es gelte zunächst, sich den aktuellen Problemen rund um autonome Fahrzeuge und Industrieroboter zu stellen. Dazu gehören etwa Datenschutz und Haftungsfragen. Und trotzdem: Zwar ist klar, dass heute bei einem Unfall mit einem autonomen System nicht die Maschinen, sondern immer noch Menschen zur Rechenschaft gezogen werden: der Programmierer, der beim Code unsorgfältig gearbeitet hat, die Herstellerin, die einen Materialfehler übersehen hat, oder vielleicht die Benutzerin, weil sie die Maschine nicht sachgemäss bedient hat. Ein Gericht muss in jedem Einzelfall entscheiden, ob jemand fahrlässig gehandelt hat. Doch das wird umso schwieriger, je komplexer die Systeme werden. «Selbst bei genauer Untersuchung ist es heute schon teils nicht mehr möglich, den Fehler zu finden», sagt Gless. So kann es sein, dass man keine Schuldigen ausmachen kann und deshalb auch niemand bestraft wird.

Strafrechtlerin Monika Simmler ist gleicher Meinung. Um herauszufinden, wie die Gesellschaft damit umgehen würde, führt sie derzeit an der Universität St. Gallen eine Studie durch. Darin sollen Probanden ohne juristisches Fachwissen in verschiedenen Fallbeispielen entscheiden, wer schuld ist: Mensch, autonomes System oder beide. Zum Beispiel, wenn ein Zug entgleist, während der Lokführer den Autopiloten eingeschaltet hatte. Dabei variiert der Autonomiegrad des Systems in fünf Stufen, von leicht unterstützend bis hin zur vollen Übernahme der Kontrolle, ohne dass der Mensch noch eingreifen kann. Simmler erwartet, dass die Probanden den Menschen umso milder bestrafen werden, je stärker das System eingegriffen hat.

Dass bei Unfällen mit autonomen Maschinen möglicherweise niemand bestraft wird, ist kein Problem für Strafrechtsprofessorin Susanne Beck von der Universität Hannover. Das sei bei anderen Technologien ähnlich, zum Beispiel beim Strassenverkehr oder bei Atomkraftwerken. Diese werden als so nützlich empfunden, dass man die potenziellen Gefahren in Kauf nimmt. Statt im Fall von Robotern über Strafen nachzudenken, müsse es zuerst einen gesellschaftlichen Diskurs darüber geben, ob und wo man künstliche Intelligenz überhaupt einsetzen will. «Wenn man sich aber dafür entscheidet, muss man auch damit leben, dass etwas schiefgehen kann.»

Was aber nicht bedeutet, dass Geschädigte leer ausgehen sollen: Damit diese nach einem Zwischenfall mit einem Roboter Schadensersatz oder Schmerzensgeld erhalten, muss die zivilrechtliche Haftung klar geregelt sein, findet Beck. Deswegen haben sie und weitere Forschende darüber diskutiert, einen eigenen rechtlichen Status für Roboter zu schaffen: die sogenannte elektronische Person oder ePerson, über die bereits das EU-Parlament beraten hat. Diese wäre vergleichbar mit der juristischen Person. Wie das Konstrukt aussehen würde, ist noch nicht klar. Eine Möglichkeit wäre, dass Hersteller, aber auch Besitzerin und Betreiberin eines Roboters verpflichtet werden, gemeinsam eine Geldsumme zu hinterlegen, mit der im Schadensfall gehaftet wird. Gegen die Einführung einer ePerson haben sich jedoch Robotikforschende in einem offenen Brief an die EU ausgesprochen. Beim heutigen Stand von künstlicher Intelligenz sei das voreilig, deren Fähigkeiten würden überschätzt. Sie fürchten aber wohl auch, dass durch eine derartige gesetzliche Vorgabe Innovationen gebremst werden könnten.

Claudia Hoffmann ist freie Wissenschaftsjournalistin und arbeitet für die WSL in Davos.